数据质量不过关,论文答辩就会踩雷

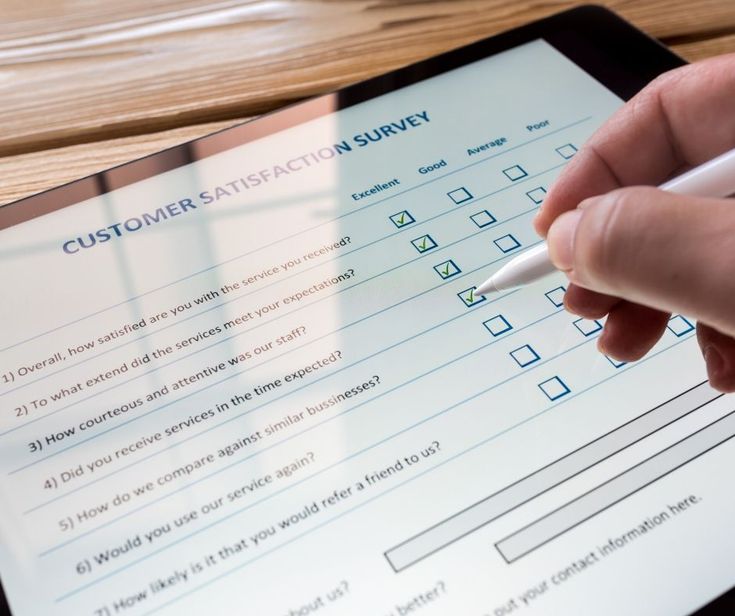

在准备问卷调查时, 研究者最常纠结的问题之一就是样本数量。 “是不是得收集100人以上?” “先多收点数据,保险一点吧。” 于是日夜发链接,努力收集, 当样本达到200人、250人时, 心里会觉得安心了许多。 但,仅有样本数量还远远不够 当你将分析结果交给导师时, 却常常收到这样的反馈: “这数据的信度太低了。” “这样的人群分布,分析不出来啊。” 也就是说, 数据数量够了,但质量不过关,等于白费。 🎯 只关注样本数量而失败的三大原因 ✅ 1. 被试筛选标准不明确 目标群体模糊, 结果混入了与研究目的不符的受访者。 ✅ 2. 无效或敷衍答卷太多 有些人全程打同一个分数, 或几秒内就完成问卷,明显不认真。 ✅ 3. 样本分布不均 过度集中于某个年龄层或性别, 导致无法进行有效的群体比较。 因此,样本数只是最低要求, 如果数据本身不可靠, 这些样本就没有任何实际价值。 ✔ The Brain 同时管理“数量 + 质量” The Brain 不仅关注样本数量, 更有一套系统化方法确保数据的可信度与有效性: ✅ 样本标准 至少收集150份以上有效问卷 可根据研究目标精确筛选目标群体 ✅ 数据质量审核 利用AI自动筛除不认真答卷 检查作答时间与答题模式 ✅ 数据清洗处理 缺失值处理 预先检查群体分布偏差 ✅ 论文输出支持 提供SPSS分析结果 附带统计表格与解释文字 教授反馈后可提供分析修正服务 The Brain 所追求的, 不是“量多”的数据, 而是能通过论文审查的高质量数据。 📌 千万别以为: “样本收够就万事大吉了。” 收集样本或许简单, 但确保数据质量,才是真正的专业能力。 今天起,请你像关注样本数一样, 认真检查你的数据质量。 The Brain 与你同行。